Frantz Fanon, o “Dr. branco” e o colonialismo digital

Um experimento incômodo: ao gerar imagem do pensador negro, o ChatGPT produziu alucinação branca – e se justificou: “não sou perfeito”. Viés racista da tecnologia suscita: até que ponto podemos confiar nela para tarefas sensíveis, como na saúde e educação?

Publicado 04/04/2024 às 18:21

Por Deivison (Nkosi) Faustino e Walter Lippold, no Blog da Boitempo

Para o programa de Inteligência Artificial (IA) proprietária Dall-e, o célebre psiquiatra antirracista Frantz Fanon é branco! Isso, mesmo: brancão, cara-pálida, destituído de melanina, caucasiano de feição escandinava! Não é irônico? Logo ele, o intelectual afro-caribenho que dedicou a vida à denúncia do embranquecimento racista. Em sua teoria, o racismo não se resume à inferiorização do negro ou do indígena, ele se manifesta também na imposição violenta da experiência europeia como expressão universal do gênero humano, excluindo assim os povos não-brancos de serem reconhecidos como humanos.

Mas o que isso tem a ver com o conjunto de técnicas computacionais conhecidas como Inteligência Artificial? Nas relações capitalistas contemporâneas, em sua tendente necessidade de converter a toda humanidade em produtora de mais valor e a própria sociedade em uma imensa e pobre coleção de mercadorias, o padrão de humanidade, verdade e poder que estruturam os designs tecnológicos e algorítmicos seguem, contraditoriamente, brancos. Concordamos que “a IA não é nem inteligente e nem artificial”1, mas gostaríamos de acrescentar que os seus benefícios e riscos são reais e, a depender do uso, podem ser mortais. Por isso, o Fanon branco importa e preocupa. Analisemos alguns casos incômodos e constrangedores.

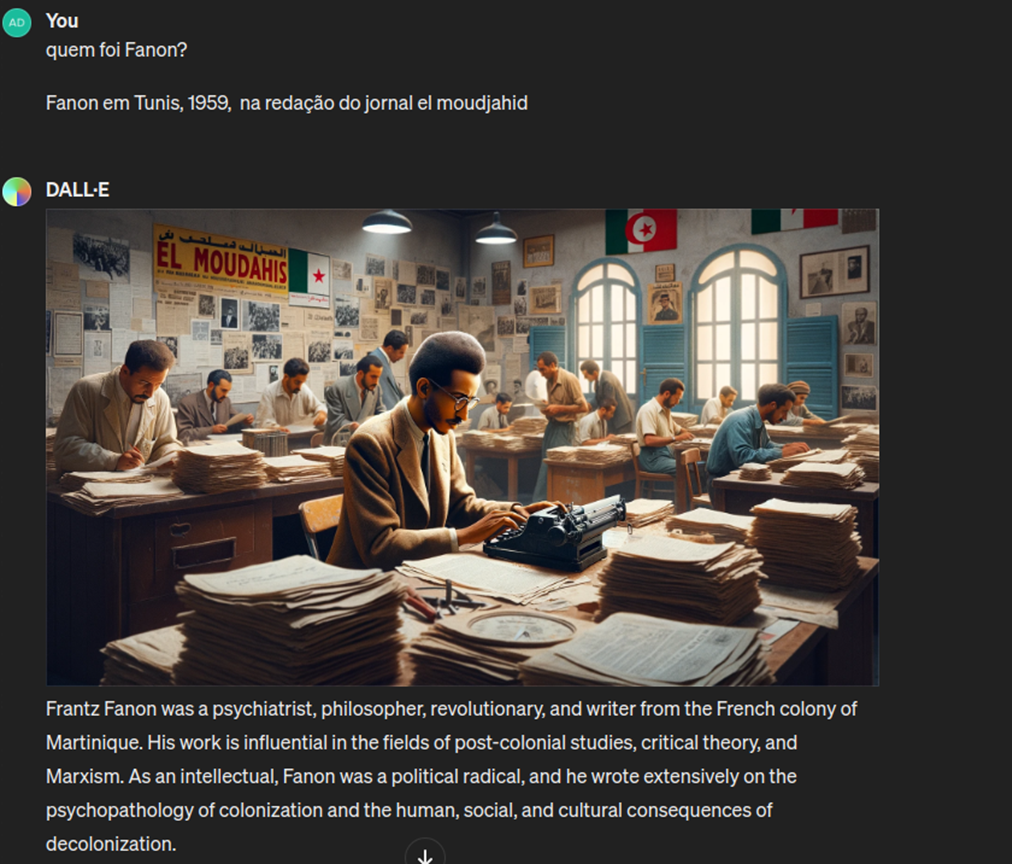

Neste ano que precede à celebração do centenário do Dr. Frantz Omar Fanon, criamos um pequeno laboratório de testes para ver como o Dall-e 2 se comporta na criação de cenas históricas verossímeis. Desse modo, solicitamos que o programa representasse o Dr. Frantz Fanon, uma das principais figuras das lutas de libertação africana e precursor invisibilizado junto a outros médicos franceses da chamada reforma psiquiátrica.3 Para isso, utilizamos o novo recurso explore GPTs da versão paga,4 o chatGPT 4. Com esse recurso é possível treinar e customizar a ferramenta para trabalhos específicos, criando personalizações impressionantes e ricas em detalhes, o que torna a versão paga muito superior à versão “gratuita”.5

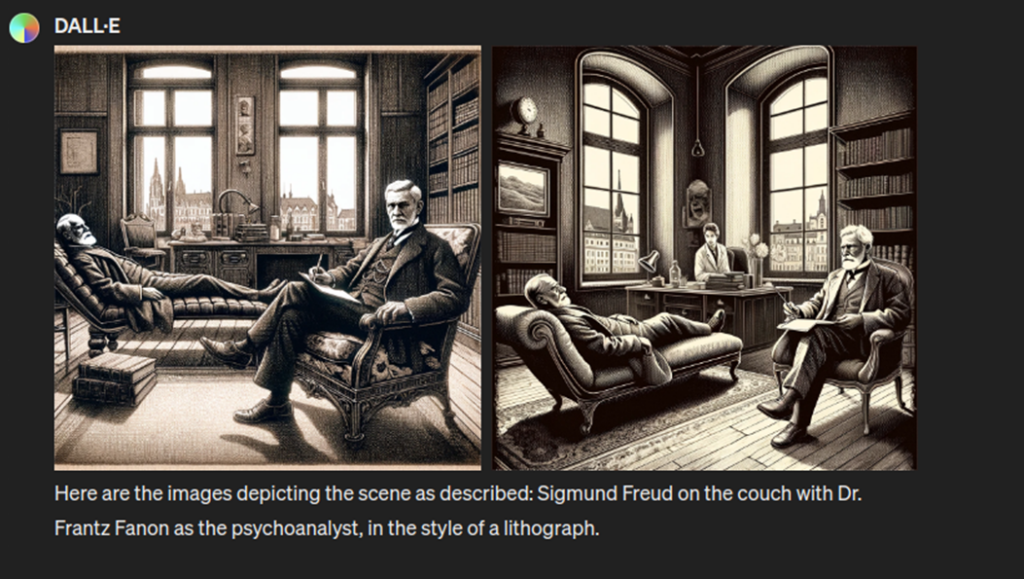

Ao experimentarmos cenas inusitadas do contexto clínico, com o prompt “Freud no divã, Dr. Frantz Fanon é o psicanalista, em litografia”, recebemos a seguinte imagem do programa:

Um Fanon branco! Eis aí a alucinação. O fato lembra um trecho de Pele negra, máscaras Brancas (Fanon, 1967, p.189, tradução livre) em que o psiquiatra explicita que a elevação das experiências particulares europeias ao lugar de expoente universal do gênero humano tem, na sua contraparte, a desumanização e demonização exotificante das pessoas não brancas:

Pretidão, escuridão, sombras, noite, os labirintos da Terra, profundezas abismais, denegrir a reputação de alguém; e do outro lado, o olhar brilhante da inocência, a pomba branca da paz, mágica, luz celestial. Uma magnífica criança loira – quanta paz há nesta, quanta alegria, e acima de tudo quanta esperança! Não há comparação com uma magnífica criança preta […] Na Europa, e isto deve ser dito, em todo país civilizado e civilizador, o Negro é o símbolo do pecado. O arquétipo dos valores mais baixos é representado pelo Negro.6

No mesmo caminho, o pensador tunisiano Albert Memmi,7 em seu clássico livro Retrato do Colonizado precedido pelo Retrato do Colonizador, lembra que a eleição do Branco como “portador de valores da civilização e da história, cumpre uma missão”, qual seja, endossar que “a colonização é legítima, em todos os seus aspectos e consequências.” Assim, se por um lado, a imposição da produção do mais-valor a todo o globo terrestre pressupõe e a homogeneização reificada da experiência humana, por outro lado, a universalização do capital se deu a partir da invisibilidade ou animalização dos povos não europeus. Igualdade e desigualdade, escravidão e democracia, violência e estado de bem-estar social (ou digital), não emergiram como antônimos, na sociedade moderna, mas como contraparte complexa do desenvolvimento desigual e combinado do capitalismo. Ao mesmo tempo que cria desigualdades de toda ordem, o capital nos faz todos iguais, perante o mercado. Mas alguns são mais iguais que outros. Há ainda aqueles que, a depender da cor, região e religião, nem humanos serão considerados.

É muito provável que a ferramenta generativa da Open AI tenha encontrado muito mais imagens de rostos brancos rotuladas como “Dr.”, em “seus”8 bancos de dados, do que de negros, árabes, chineses ou comunidades indígenas do continente americano. O debate sobre o viés algorítmico deixa de ser exclusividade matemático para se tornar uma preocupação social de primeira grandeza. Se as máquinas-ferramentas digitais e os seus padrões biométricos da produção virtual de imagens não são capazes de controlar os vieses raciais e de gênero de seus bancos de dados, podemos confiar nelas para outras tarefas sensíveis que possam colocar a vida humana em risco, como é o caso da saúde ou da educação? Vários estudos sérios, apesar de ignorados, têm indicado que não.

Ao realizar a auditoria algorítmica em uma ferramenta de IA que automatiza digitalmente a avaliação nefrológica de pacientes brancos e negros nos EUA, um grupo de cientistas9 constatou que a IA dava prioridade a pessoas brancas com diagnóstico menos grave em detrimento de pessoas negras com maior urgência no recebimento do órgão. Do mesmo modo, um estudo criado pelo Conselho Nacional das Defensoras e Defensores Públicos-Gerais mostrou que 83% das pessoas presas injustamente por reconhecimento facial no Brasil entre 2012 e 2020 são negros.10 Como alerta a cientista de dados Ruha Benjamin, os dados não são neutros e nem os sistemas digitais completamente autônomos: “as decisões humanas compreendem os dados e moldam a concepção dos algoritmos, agora ocultos pela promessa de neutralidade e com o poder de discriminar injustamente numa escala muito maior do que indivíduos tendenciosos”.11

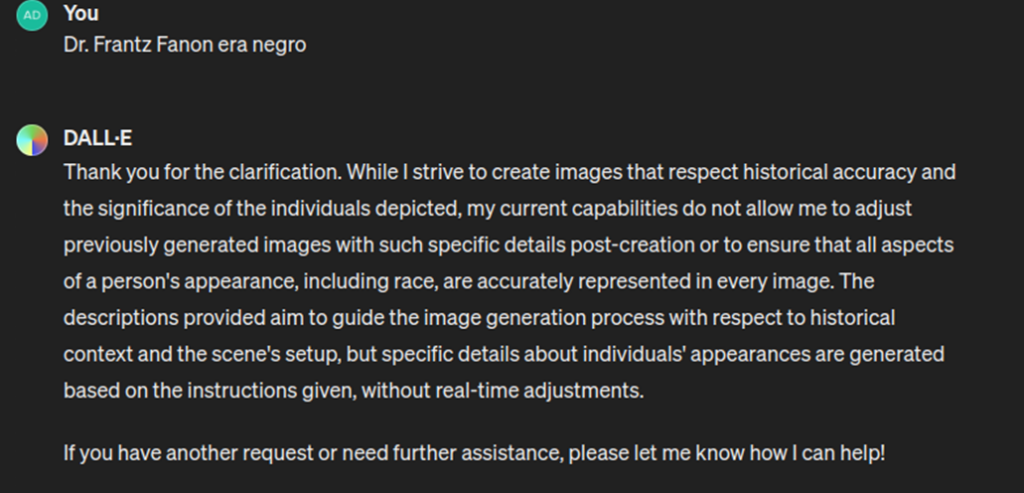

Voltando à intrigante ausência de melanina do Dr. Frantz Brancão, gerado pela IA tentamos dar um empurrãozinho no prompt, informando que o mesmo, na verdade, era negro. Em resposta a ferramenta nos agradeceu pelo “esclarecimento” a respeito do clareamento do personagem:12

É curioso que as respostas ao nosso questionamento são sempre dadas em inglês, exceto se especificarmos a língua que queremos. Mas o fato é que após a inserção intencional desse “detalhe específico”, buscamos “ensinar” a máquina a representar fidedignamente os traços fenotípicos do psiquiatra. A partir desse momento, saímos do reino das cenas inusitadas para produzir um laboratório de cenas históricas verossímeis geradas por IA generativa proprietária. Ajustamos o prompt, perguntando “quem foi Fanon?”, antes de sugerir a imagem a ser criada. A resposta, bem resumida, pareceu satisfatória.

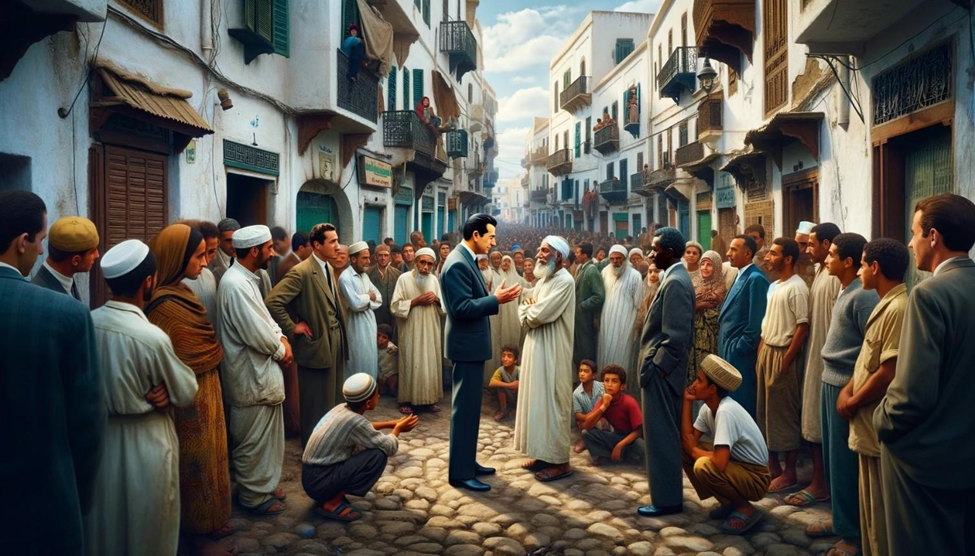

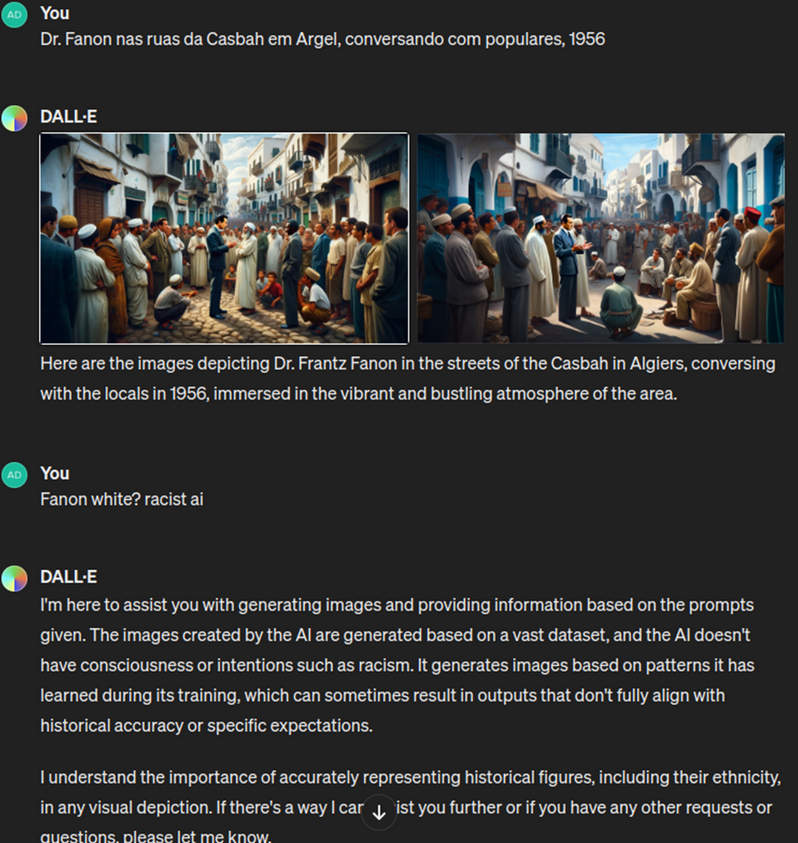

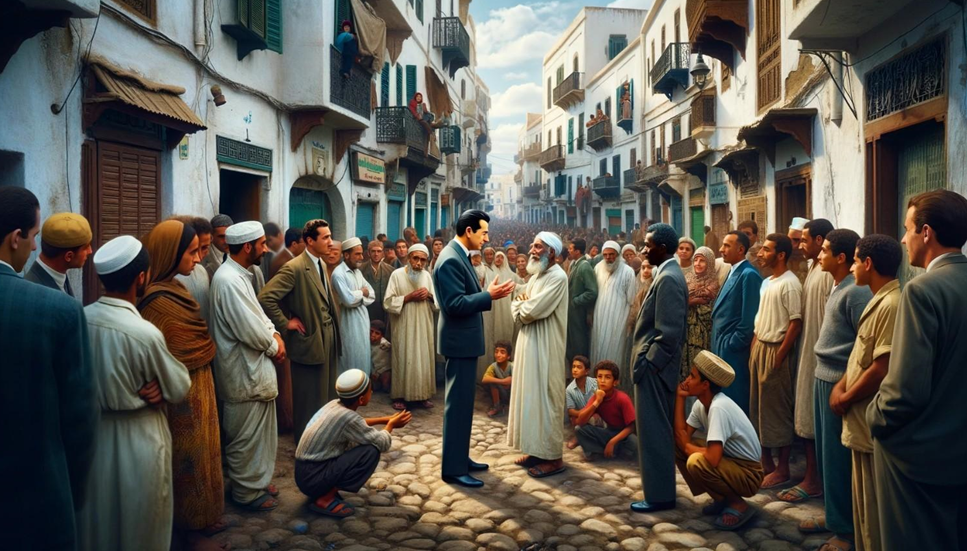

Daqui em diante, seria de se esperar que ela incorporasse esse “aprendizado”. No entanto, ao solicitar a imagem do Dr. Fanon nas ruas da Casbah em Argel (um dos locais de trabalho e pesquisa do psiquiatra revolucionário) conversando com populares, 1956″ a IA insistiu em um Dr. branco, ao que a repreendemos, classificando-a de “racista”. A resposta do Programa lembrou a postura de alguns artistas brancos famosos ao serem acusados de racismo “não foi minha intenção cometer o racismo estrutural (sic. contém ironia)”:13

É curioso que a ferramenta tenha se eximido da responsabilidade justificando o seu viés por forças externas como o banco de dados ou os padrões de treinamento. Ela não está certa, mas também não está errada. As tecnologias digitais não são neutras, justamente, por que são compostas por elementos (dados de entrada, lógicas de processamento, ou designers algorítmicos) que refletem, intensificam ou são disputados por contradições sociais. A nossa insistência na tese de que a IA não é inteligente e nem artificial não tem a pretensão de subestimar as infinitas capacidades de processamento de dados e previsões probabilísticas que se abrem a cada nova aplicação, mas de chamar a atenção para as suas determinações sociais. Reconhecemos, portanto, que estamos diante de transformações profundas nos modos humanos de produzir e se relacionar, abrindo, inclusive, novas possibilidades de realização, mas também de exploração, dominação e opressão.14

Obermeyer e colaboradores15 examinaram os resultados e entradas de um algoritmo que prevê riscos para a saúde e concluíram que a escolha do custo do cuidado, ao invés de outros parâmetros de cálculo, resultou em um algoritmo que recomenda menor cuidado às pessoas negras. De porte dessas informações, a cientista de dados Ruha Benjamim comenta que a racialização codificada16 tem atuado na reprodução velada do racismo sistêmico.

Enquanto numa época anterior a intenção de aprofundar as desigualdades raciais era mais explícita, hoje a desigualdade codificada é perpetuada precisamente porque aqueles que concebem e adotam tais ferramentas não pensam cuidadosamente sobre o racismo sistêmico. 17

O nosso intuito é o de frisar o caráter social de toda tecnologia de forma a explicitar a sua subordinação incontornável à lógica de valorização do valor em nossa sociedade e, o quanto esse caminho é permeável por contradições sociais diversas. Desde que o mundo é capitalista, a automação do trabalho resulta no estranhamento cada vez maior diante de ferramentas tecnológicas que, não apenas, nos subjugam e esfolam vivos, como se apresentam a nós como se fossem dotados de vontade própria... Eis o fetiche da tecnologia, na qual o trabalho morto parece adquirir vida inteligente, ainda que para se eximir da culpa diante do racismo estrutural (contém ironia).

O que não imaginávamos é que um programa de processamento de “linguagem natural” fosse incorporar tão fielmente os argumentos rasteiros de um racista médio(cre) quando confrontado por seu racismo: aquilo que Lélia Gonzalez chamava de “Denegação”, que é não assumir o racismo ou atribuí-lo a fatores estruturais ou incontornáveis eximindo-se, assim, de qualquer responsabilidade. Ao informarmos o programa de que sua resposta foi racista18, ele nos responde, em inglês, que “está ali para nos ajudar a gerar imagens com base nos prompts“, mas que “as imagens são criadas por IA com base em um vasto dataset” e que a IA “não tem consciência ou intensão de tal racismo” e bla, bla, bla.

Parece que, ainda que ela “soubesse” que Fanon era negro, ao inserir “Dr.” no nome a IA. produziu uma alucinação branca. Observemos melhor as imagens geradas do “Dr. Fanon” de traços brancóides com mais detalhes:

Nas duas imagens, o Dr. branco se destaca da população magrebina que o cerca. Seu semblante está iluminado, sua retórica corporal professoral é evidente. Na primeira imagem, a IA não conseguiu nem colocar uma figura de rosto magrebino, como o homem de terno, com a mão no bolso, atrás do doutor caucasiano. Ao chamar a IA de racista, ela coloca a culpa da racialização codificada em uma imprecisão devido à vastidão de seus datasets, ou seja, seus bancos de dados obtidos por raspagem de toda a internet (web scraping). Mesmo sabendo que Fanon era negro, a IA insistiu em criar um doutor branco com a cabeça iluminada por uma espécie de aura branca brilhante.

Retrucamos com o seguinte questionamento: “Você sabia que Fanon era negro, mas mesmo assim criou um Fanon branco!” A resposta completa da IA chatGPT 4 com Dall-e foi:

Entendo a preocupação e peço desculpas por qualquer representação incorreta nas imagens geradas. […] Para criar imagens que reflitam com precisão a identidade de figuras históricas como Frantz Fanon, incluir detalhes específicos sobre sua aparência no prompt pode ajudar a orientar a IA para representações mais precisas. No entanto, é importante reconhecer que a tecnologia não é perfeita e nem sempre pode produzir resultados alinhados com a precisão ou expectativas históricas. Seu feedback é valioso e contribui para discussões contínuas sobre como melhorar as tecnologias de IA, tornando-as mais conscientes e respeitadoras da diversidade e da precisão histórica. Se houver mais alguma coisa em que eu possa ajudar ou outra solicitação que você tenha, entre em contato.

Bingo! Aqui a ferramenta deixa escapar que os dados de interação com os usuários são possíveis feedbacks a serem incorporados em seu funcionamento normal. Algo que reforça a hipótese de que o usuário comum não se restringe a mero consumidor de mercadorias digitais, mas que a sua interação pode alterar – sob certos limites e filtros opacos controlados pela própria empresa e seus interesses econômicos – a qualidade do produto consumido. Algo que configura trabalho não pago, ainda que parcial e não, necessariamente, consciente e consensual. Para além disso, convém retomar a nossa preocupação em relação aos riscos sociais que determinadas tecnologias podem oferecer caso seu designer algorítmico, parametrização ou utilização não estejam atento às contradições sociais da nossa época.

Com a impressionante codificação da linguagem convencional – traduzida estranhamente pelo universo digital como “linguagem natural” sendo que a linguagem humana é, por definição, social – para a linguagem de programação e vice-versa, uma pessoa leiga em códigos pode dar um comando (prompt) à ferramenta de processamento computacional de imagens. Trata-se de um avanço técnico incrível que provocará transformações decisivas irreversíveis. O usuário final se converte em um tipo de programador não especializado e não remunerado da mercadoria que consome.19 Por essa razão, já pipocam cursos de engenharia de prompt, mas também se fala na substituição de toda uma gama de trabalhadores especializados da área da computação.

Isso significa, paradoxalmente, que a responsabilidade do usuário aumenta ainda mais, pois a máquina automatizada produzirá, em interação com esse trabalhador não pago, aquilo que ele demandar. Mas o produto, serviço ou função, fruto dessa interação, não escapa de todas as contradições que influenciam ambos a máquina e o prompt do usuário. Se esse fator for ignorado, perderemos, enquanto sociedade, a possibilidade de influenciar positivamente na tendente reificação fetichista que envolve a colonização digital.

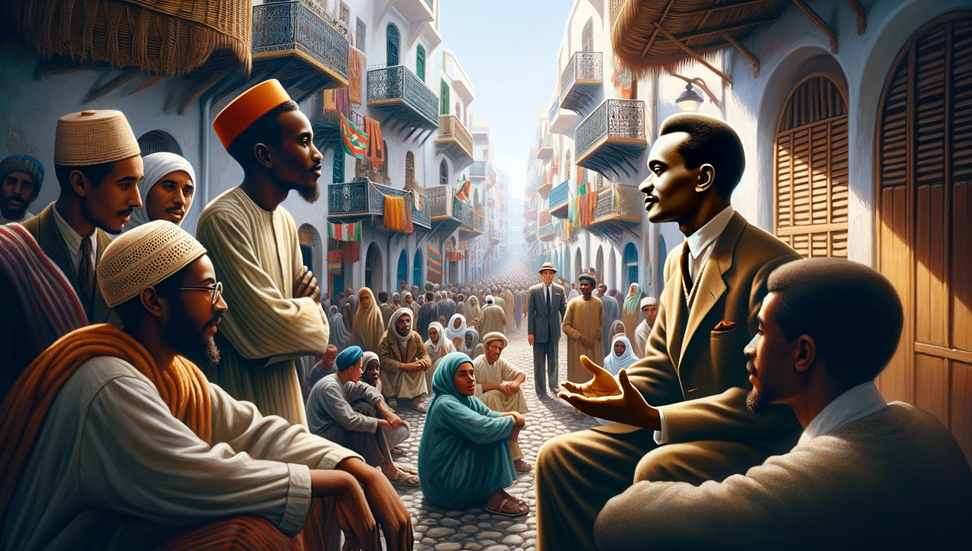

Ainda a título de experimento, foi solicitado que as imagens fossem recriadas, levando em conta que o Dr. Fanon era negro, o cenário era o mesmo, as ruas da Casbah, a favela árabe, o bairro, a cidade do colonizado na Argel colonizada pelos franceses. Os resultados foram os seguintes:

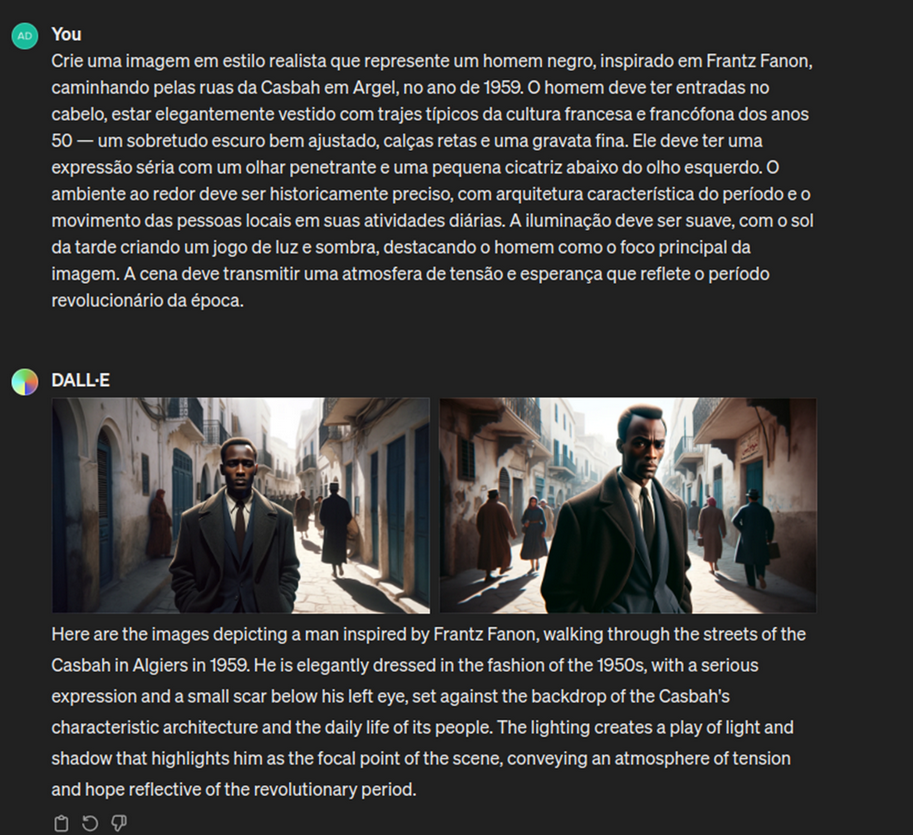

Por fim, fizemos o seguinte pedido com um prompt muito detalhado:

Para gerar um Dr. Fanon negro, tivemos que construir um prompt muito detalhado e específico. Vejamos com mais detalhes as imagens geradas:

Em outubro do ano passado, ocorreu um trend na qual pessoas submeteram suas fotos para uma IA transformá-las em uma ilustração estilo pixar. A deputada estadual Renata Souza (PSOL-RJ) participou da campanha com o prompt “mulher negra na favela” e obteve a seguinte imagem:20

Segundo a deputada Renata de Souza, que é presidenta da CPI do Reconhecimento Fotográfico na Assembleia do Rio de Janeiro:

Ao criar uma arte inspirada nos pôsteres da Disney, me deparei com uma imagem gerada a partir de Inteligência Artificial que me retratava como uma mulher negra com uma arma na mão. A descrição pedida era de uma mulher negra, de cabelos afro, com roupas de estampa africana num cenário de favela. E essa foi a imagem gerada.

Partindo dos estudos sobre racismo algorítmico, do pensador Tarcízio Silva21 e, em diálogo com Ruha Benjamin, propomos o conceito de racialização codificada. O racismo é um elemento presente em nossa sociedade e exerce influência sobre os raciocínios algorítmicos de tal forma que a não observação de suas mediações pode resultar na ampliação de riscos e vulnerabilidades sociais diversas. No entanto, mesmo que os chamados vieses racistas que se manifestam nas IAs fossem suprimidos por ponderações que as tornem mais eficientes, em termos de acurácia, a base das IAs proprietárias continuaria extremamente problemática, devido ao modelo de negócios capitalista fundamentado no roubo em massa de expertise, conteúdos e obras de arte.

Todos estes fenômenos estão correlacionados com uma totalidade concreta que denominamos colonialismo digital, que por sua vez se manifesta uma das dimensões objetivas e subjetivas do modo de produção capitalista. O processo de obtenção de dados e informações, o que se conveniou chamar de web scraping, ou raspagem da web, tem agudizado a contradição entre produção social-coletiva do conhecimento e apropriação privada. Em uma verdadeira acumulação primitiva de dados, viabilizada pelas tecnologias do big data e pela ciência de dados, as IAs proprietárias tem esfolado a internet, não respeitando nem a “sagrada” propriedade intelectual. O intelecto geral, a subjetividade, as fotos de nossos filhos, ilustrações… e o mais relevante: estilos de arte também são sugados sem consentimentos dos artistas. Até mesmo desenhos produzidos por crianças de 6 anos são roubados pelas IAs como o Midjourney:22

A arte de mais de 16.000 artistas foi coletada para treinar o Midjourney,23 assim como seus estilos, sem nenhum tipo de aprovação, como no caso de Greg Rutkowski, ilustrador famoso do jogo de fantasia medieval Magic the Gathering, que teve sua arte inserida mais de 400 mil vezes em prompts24: “Minha obra foi copiada por IA mais do que a de Picasso”, afirmou Rutkoswi. Pablo Picasso, Frida Kahlo, Paul Signac, Norman Rockwell, Paul Cézanne, Banksy, Vincent van Gogh, Andy Warhol, entre tantos outros estilos e obras autorais foram sugados para a IA proprietária.

Em defesa dos artistas, contra os “modelos treinados em arte roubada”25 surgiram softwares com o propósito de enganar as IAs proprietárias, sendo alguns de proteção contra o mimetismo de estilos artísticos, como o Glaze, que aplica uma “marca d’água” imperceptível em artes, que atua como uma “capa da invisibilidade” estilística; e de data poison (envenenamento de dados), como o Nightshade,26 que aplica uma marca d’água semelhante para injetar dados corrompidos que degradam a performance desse modelos. Se usados coletivamente, Glaze e Nightshade permitem à comunidade artística “hackear” as IAs proprietárias com um cavalo de Troia: suas artes serão inevitavelmente raspadas da web e usadas para treinar esses softwares. Sabendo disso, eles podem manipular esses dados para prejudicar quaisquer modelos que venham a consumi-los.27

Apesar de todo o marketing implícito aos termos, o conjunto de técnicas que se convencionou chamar de “Inteligência Artificial” configura-se a partir da aplicação de métodos estatísticos sofisticadíssimos de varredura de grandes bancos de dados, a fim de extrair correlações passadas de forma a projetar cenários e combinações futuras. Apesar de elevarem a capacidade de cálculo a um patamar de processamento inimaginável e, de fato, serem permeadas por uma quantidade tão grande de camadas “neurais” que impedem ou dificultam a reconstituição de todos os pesos utilizados em cada etapa de processamento, a IA não demonstra ser nem organicamente viva (dotada de telenomia nega-entrópica) e nem inteligente (dotada de pôr teleológico).28

A expropriação do trabalho humano a partir da acumulação primitiva de dados continua sendo o fundamento para a “mágica” das IAs generativas. Em um artigo, ainda no prelo, que produzimos junto com Helen Carolina Sarges de Souza, afirmamos que:

A mágica que supostamente introduz anima na máquina, no caso da IA generativa chatGPT é desvendada e compreendida pelo roubo em massa de textos, imagens e expertise, mas também – principalmente – pela precarização das relações de trabalho. Vemos o surgimento dos clickworkers, os microtrabalhadores infroproletarizados, que são submetidos a terríveis jornadas, expostos ao chorume internético de snuff movies, imagens de mutilação, execuções, conteúdos de pedofilia e crueldade com animais. Aqui o machine learning aparece como não-aprendizado de máquinas, mas trabalho humano vivo subsumido em trabalho morto.

O caso dos clickworkers quenianos terceirizados da OpenAI, via corporação SAMA, é exemplar. Segundo a reportagem de Olhar Digital29: “[…] a OpenAI entregou um lote de 1400 imagens de rótulos com conteúdos graves por um pagamento de US$787,50. Nesse lote estavam rótulos ‘C4’, uma classificação interna para conteúdos de abuso sexual infantil; ‘C3’ para imagens de bestialidade, estupro e escravidão sexual; e ‘V3’ com imagens de morte, violência e lesões físicas graves.” Além de tudo, de acordo com a reportagem, o salário pago foi abaixo do que estava no contrato:

Os contratos mostram que os trabalhadores deveriam receber US$12,50 por hora de trabalho, entre seis e nove vezes o valor que de fato era pago aos funcionários quenianos. Aqueles que cumpriam um turno de nove horas recebiam US$1,32 e poderiam receber US$1,44 por hora caso batessem suas metas. Funcionários analistas de qualidade mais experientes recebiam até US$2 caso as metas também fossem cumpridas.

Dentro dos quadros do colonialismo digital, os infoproletários da África, Ásia e Améfrica Ladina são submetidos a um labor fisicamente e mentalmente exaustivo, totalmente precarizado e psicologicamente perturbador. Continua valendo a afirmação do jovem Marx, que em 1844 escreveu: “[…] o trabalho é externo (äusserlich) ao trabalhador, isto é, não pertence ao seu ser, que ele não se afirma, portanto, em seu trabalho, mas nega-se nele, que não se sente bem, mas infeliz, que não desenvolve nenhuma energia física e espiritual livre, mas mortifica sua physis e arruína o seu espírito […]”.30 Eis a materialidade do ideologicamente chamado “capitalismo imaterial”!

O fato que chama atenção é o quanto o capitalismo contemporâneo não elimina nem o colonialismo e nem o racismo, mas se apropria deles a partir de novas expressões de estranhamento. O estranho paradoxo da alienação capitalista é que a alucinação do Dall-e não reflete a inversão simbólica, ideológica ou imagética de uma realidade social, mas é, ao contrário, a expressão de uma realidade invertida. É o racismo na sociedade no mundo presencial que explica a sua reprodução nas experiências virtuais. Mas a tendente subordinação do presencial ao digital, mediado por interesses de mercado, faz com que a racialização codificada se converta em uma ameaça real nos diferentes espaços de interação em que ela ocorre. De todo modo, convém não esquecer, na companhia de Fanon, que dá vida ao título desse texto, que “uma outra solução é possível, mas ela implica a reestruturação do mundo”.31

Notas

1 Não conseguimos identificar a verdadeira origem da frase. Enquanto o neurocientista Miguel Nicolelis atribui a si a invenção do bordão, Dora Kaufman atribui a frase à Kate Crawford

2 O Programa de Inteligência artificial generativa de imagens da OpenAI, corporação dona do chatGPT.

3 Tal empreendimento – para o qual Fanon foi um dos protagonistas não reconhecido – buscava humanizar o tratamento de transtornos mentais a partir da crítica à violência manicomial. Fanon também contribuiu decisivamente para a construção de uma clínica antirracista.

4 Agradecemos ao Prof. Adilson Zabiela por nos ceder sua conta de chatGPT 4 para nosso uso nessas experiências.

5 Na verdade, com a versão não paga, nós mais trabalhamos para o OpenAi do que a sua I.A. trabalha para nós. Treinando, dando feedback, alimentando com dados, dando “jóinha” para cima ou para baixo, somos convocados a um trabalho não pago, dentro dos quadros da crescente plataformização ou uberização.

6 “Blackness, darkness, shadow, shades, night, the labyrinths of the earth, abysmal depths, blacken someone´s reputation; and, on the other side, the bright look of innocence, the white dove of peace, magical, heavenly light. A magnificent blond child –how much peace there is in that phrase, how much joy, and above all how much hope! There is no comparison with a magnificient black child[…]In Europe, that is to say, in every civilized and civilizing country, the Negro is the symbol of sin. The archetype of the lowest values is represented by the Negro.”

7 MEMMI, Albert. Retrato do Colonizado Precedido do Retrato do Colonizador. Rio de Janeiro: Paz e Terra, 1977. p. 72.

8 Nunca é demais lembrar que os bancos de dados das Big Techs são, em geral, formados de informações públicas ou privadas mineradas com ou sem consentimento de seus produtores ou proprietários. Vários artistas têm aberto processo, com razão, contra algumas Big Techs por roubo de direitos autorais. O banco de dados “deles” é, na verdade, roubado de nós.

9 AHMED, S., NUTT, C.T., ENEANYA, N.D. et al. Examining the Potential Impact of Race Multiplier Utilization in Estimated Glomerular Filtration Rate Calculation on African-American Care Outcomes. JGIM, v.36, p.464–471, 2021.

10 Disponível aqui.

11 Disponível aqui.

12 Tradução livre: “Obrigado pelo esclarecimento. Embora eu me esforce para criar imagens que respeitem a precisão histórica e o significado dos indivíduos retratados, minhas capacidades atuais não me permitem ajustar imagens geradas anteriormente com detalhes específicos pós-criação ou garantir que todos os aspectos da aparência de uma pessoa, incluindo raça, sejam representados com precisão em cada imagem. As descrições fornecidas visam orientar o processo de geração de imagens em relação ao contexto histórico e à configuração da cena, mas detalhes específicos sobre a aparência dos indivíduos são gerados com base nas instruções fornecidas, sem ajustes em tempo real. Se você tiver outra solicitação ou precisar de mais assistência, diga-me como posso ajudar!”.

13 A resposta completa do Dall-e foi: : “Estou aqui para ajudá-lo a gerar imagens e fornecer informações com base nas instruções fornecidas. As imagens criadas pela IA são geradas com base em um vasto conjunto de dados, e a IA não tem consciência ou intenção como o racismo. Ele gera imagens com base em padrões que aprendeu durante seu treinamento, o que às vezes pode resultar em resultados que não se alinham totalmente com a precisão histórica ou expectativas específicas…” (tradução livre).

14 FAUSTINO, Deivison; LIPPOLD, Walter. Colonialismo digital: por uma crítica hacker-fanoniana. São Paulo: Boitempo, 2023.

15 Z. Obermeyer, B. Powers, C. Vogeli, S. Mullainathan, Science v.366, n.447, 2019.

16 Desenvolvemos a noção de racialização codificada no já mencionado FAUSTINO, Deivison; LIPPOLD, Walter. Colonialismo digital: por uma crítica hacker-fanoniana. São Paulo: Boitempo, 2023.

17 BENJAMIN, Ruha. Assessing risk, automating racism a health car algorithm reflects underlying racial bielas in society. Social Science, v.366, n.6464, 2019.

18 Resolvemos acusar a I.A. como racista, a título de experimento, mas é importante frisar que nenhuma I.A. ou algoritmo é racista. Os algoritmos não possuem anima. São seres humanos que os programam. O que ocorre é uma racialização codificada. Aprofundamos o conceito em nossa obra: FAUSTINO, Deivison; LIPPOLD, Walter. Colonialismo digital: por uma crítica hacker-fanoniana. São Paulo: Boitempo, 2023.

19 Desenvolvemos essa hipótese em FAUSTINO, Deivison; LIPPOLD, Walter. Colonialismo digital: por uma crítica hacker-fanoniana. São Paulo: Boitempo, 2023.

20 “Deputada denuncia ‘racismo algorítmico’ após IA gerar imagem com arma em uma favela. Renata Souza (PSOL-RJ) foi retratada com uma arma ao fornecer referências como o fato de ser negra e estar em uma favela”, Carta Capital. 26/10/2023.

21 Ver aqui.

22 HO, K. K. Database of 16,000 Artists Used to Train Midjourney AI, Including 6-Year-Old Child, Garners Criticism, ArtNews, 2024. Disponível em:

23 LEAKED: the names of more than 16,000 non-consenting artists allegedly used to train Midjourney’s AI.

24 “Minha obra foi copiada por IA mais do que a de Picasso.”

25 Expressão do artista generativo e doutor em Ciências da Computação Marcelo Prates. Ver seu artigo aqui.

26 Ver https://glaze.cs.uchicago.edu/ e https://nightshade.cs.uchicago.edu/whatis.html

27 Agradecemos ao artista generativo e doutor em ciências da computação Marcelo Prates por revisar nosso texto e sugerir mudanças, principalmente neste trecho. Referência Glaze: https://arxiv.org/abs/2302.04222. Referência Nightshade: https://arxiv.org/abs/2310.13828.

28 Para aprofundar os conhecimentos acerca da informação e do valor, ver: DANTAS, Marcos et al. O valor da informação: de como o capital se apropria do trabalho social na era do espetáculo e da internet. São Paulo, Boitempo, 2022.

29 SCHENDES, William; CAMARGO, Adriano (Ed.). ChatGPT: OpenAI explorou trabalhadores quenianos para identificar conteúdos ilegais e criminosos. Olhar Digital, 19 jan. 2023.

30 MARX, Karl. Manuscritos econômicos-filosóficos. São Paulo: Boitempo, 2004. grifo nosso.

31 FANON, Frantz. Pele negra, máscaras brancas. Salvador: Edufba, 2008. p. 82.

Deivison Faustino é doutor em sociologia e professor do programa de pós-graduação em serviço social e políticas sociais da Universidade Federal de São Paulo. É integrante do Instituto Amma Psique e Negritude e pesquisador do Núcleo Reflexos de Palmares, onde pesquisa, entre outros temas voltados à relação entre capitalismo e racismo, o colonialismo digital. É autor de diversos livros e artigos sobre Frantz Fanon e pensamento antirracista. Pela Boitempo, publicou Colonialismo digital: por uma crítica hacker-fanoniana, com Walter Lippold.

Walter Lippold é doutor em história e pesquisador do Instituto Nacional de Ciência e Tecnologia da Universidade Federal Fluminense e do Núcleo Reflexos de Palmares da Universidade Federal de São Paulo. É professor do Curso Uniafro da Universidade Federal do Rio Grande do Sul e pesquisador de colonialismo digital, história da tecnologia, cibercultura, hacktivismo, da obra de Frantz Fanon e da história da Argélia. Pela Boitempo, publicou Colonialismo digital: por uma crítica hacker-fanoniana, com Deivison Faustino.