Quando a tecnologia nos envia ao passado

Mais polêmica sobre Inteligência Artificial. Cientista etíope provoca: concebidos por grupos dominantes, algoritmos eternizam desigualdade e preconceitos; é preciso reescrevê-los. Mas corporações da internet rejeitam abrir suas caixas pretas

Publicado 25/11/2020 às 21:29 - Atualizado 23/12/2020 às 16:30

Abeba Birhane, entrevistada por Joe Humphreys, no Irish Times | Tradução de Simone Paz

Os humanos crêem que é muito difícil livrarem-se do preconceito. Poderia a inteligência artificial (IA) sair-se melhor, ao tomar decisões que não distinguem gênero, cor ou credo?

As primeiras impressões não são nem um pouco encorajadoras. Pesquise na internet por fotos aleatórias de “CEO” e você será bombardeado por dezenas de fotos de homens, principalmente brancos. Se as configurações de dados forem tendenciosas desde o começo, seus resultados também serão contaminados, reforçando percepções antiquadas.

Agora, pense em todas as áreas nas quais estamos começando a ceder espaço aos algoritmos: no recrutamento de empregos (aplicativos de triagem), policiamento (identificação de suspeitos), bancos (aprovações de empréstimos)… a lista é imensa. E isso acontece em um momento em que a tecnologia ainda está engatinhando.

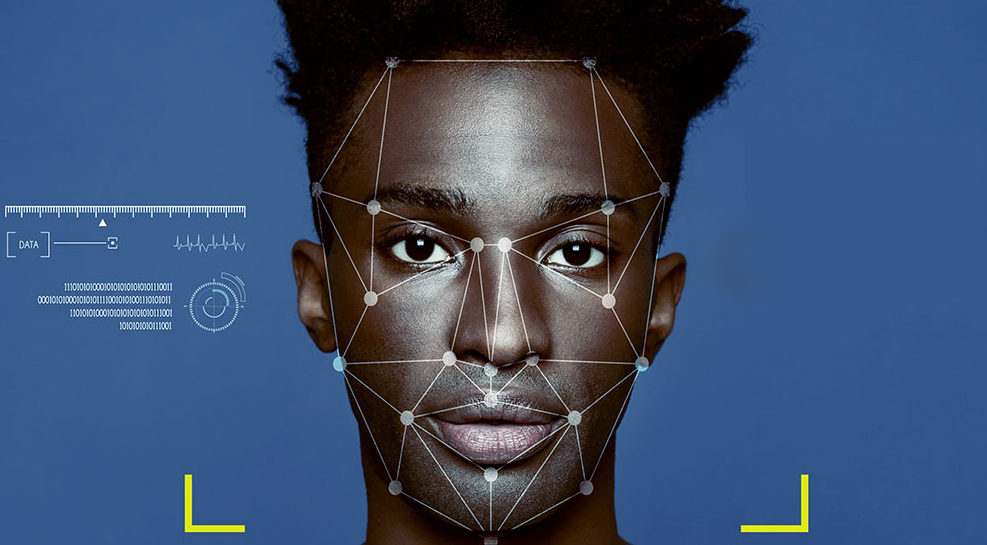

Os testes demonstraram que mesmo sistemas de reconhecimento facial de alto desempenho identificam os negros erroneamente, em proporções de cinco a dez vezes mais altas do que os brancos. Apesar disso, essa tecnologia já está sendo implementada — inclusive em Londres, onde a polícia começou a usá-la no início deste ano.

Alguns cientistas de dados — principalmente mulheres — vêm alertando sobre o preconceito algorítmico já há algum tempo; mas, mesmo assim, a corrida em direção a um futuro controlado pela IA continua.

Apontando para a falta de transparência em torno dos algoritmos e também sua capacidade de ampliar o racismo e o sexismo, a matemática norte-americana Cathy O’Neil cunhou a frase “algoritmos são opiniões embutidas em código”. Em sua pesquisa, Shoshana Zuboff, uma estudiosa de Harvard, destaca o impulso comercial que sustenta a IA e como os sistemas algorítmicos estão sendo usados para turbinar o “capitalismo de vigilância”.

Outra grande crítica é Abeba Birhane, cientista cognitiva nascida na Etiópia e hje baseada na Universidade de Dublin (Irlanda). Ela ajudou recentemente a descobrir termos racistas e misóginos em uma biblioteca de imagens do Massachusetts Institute of Technology (MIT), que era utilizada para o treinamento da IA. O MIT, desde então, retirou o banco de dados — uma pequena vitória no que deve vir a ser uma longa guerra.

Birhane, que é doutoranda (PhD) no Laboratório de Softwares Complexos da Escola de Ciências da Computação da UCD e no Lero: Centro de Pesquisa de Software da Fundação de Ciências da Irlanda, é nossa entrevistada de hoje.

Por que não entregar a tomada de decisões aos algoritmos, se eles podem ser programados para serem mais objetivos do que nós?

Esse é um dos pensamentos mais persistentes — a ideia de que se trabalharmos o suficiente e tivermos dados ou algoritmos bons o suficiente, colheremos resultados melhores e menos tendenciosos do que os de seres humanos. Mas acho que esse é um dos maiores equívocos, em vários aspectos.

Filosoficamente falando, quando abordamos questões sociais — seja sobre a projeção de um algoritmo para encontrar o melhor candidato a uma vaga; ou na esfera da justiça criminal, para identificar pessoas com maior probabilidade de cometer crimes — qualquer uma dessas aplicações pressupõe que podemos, de alguma maneira, consolidar dilemas sociais dinâmicos, ambíguos e em constante mutação, e resolvê-los, encontrar uma “solução” para eles… Isso parte de um pensamento muito reducionista.

Mas deixando a filosofia de lado, esta ilusão também é muito problemática do ponto de vista ético. Os modelos de IA são muito bons em encontrar padrões e semelhanças, e a maioria dos modelos preditivos são construídos com base em dados históricos, em modelos nos quais esses padrões históricos são tomados como verdade fundamental. Só que nós sabemos que o passado está cheio de injustiças e de práticas discriminatórias.

Além disso, a integração de sistemas algorítmicos na esfera social muitas vezes surge da necessidade de tornar a vida mais fácil para aqueles que já estão em posições de poder, não do desejo de proteger e beneficiar o usuário final.

Há algo que possa ser feito para o uso de algoritmos em tarefas limitadas?

Não quero ser totalmente inflexível e dizer que de nada adianta construir sistemas preditivos. Mas tudo se resume ao que você vai tentar fazer com eles, qual é seu objetivo e a quem seu modelo acaba fortalecendo.

Meu lema é que, a menos que um sistema algorítmico tenha sido examinado e passado por uma avaliação crítica, você pode assumir que ele perpetua o status quo, repete o passado e prejudica minorias, indivíduos e comunidades desfavorecidas.

As grandes corporações de tecnologia de informação recusam-se a revelar como seus algoritmos funcionam em bases comerciais. Precisamos transformar esses mecanismos em propriedade pública ou, pelo menos, torná-los transparentes

Sim, às vezes me parece realmente um absurdo termos empresas privadas tomando decisões políticas e éticas sobre assuntos que temos debatido por tanto tempo na esfera pública e onde não há uma única resposta correta. Usando sistemas de reconhecimento facial para monitorar “atividades criminosas”, por exemplo, ou usando uma ferramenta para decidir quem merece receber assistência social.

São desafios contínuos e questões em aberto. Por mais que as empresas privadas, que vêm com seus algoritmos, tratem deles como meras questões matemáticas ou técnicas que podem ser “resolvidas” de uma vez por todas.

Seus algoritmos substituem cada vez mais — ou, melhor, acabam com o debate e diálogo em andamento, sem que sejam responsabilizados ou examinados. Por quê? Porque eles se escondem atrás de direitos de propriedade, reivindicando o direito de manter seu código e dados ocultos. Juízes ou órgãos do Estado que tomassem decisões semelhantes estariam sujeitos a uma fiscalização muito maior. Agora, temos essas empresas tomando decisões, escondidas atrás de um algoritmo — como se estivessem apenas fornecendo uma solução técnica, e não decidindo sobre questões sociais e políticas.”

Há uma consciência crescente da discriminação racial e de gênero na ciência. As coisas estão começando a mudar?

Tenho uma opinião bem dividida sobre isso. Às vezes me sinto muito otimista. Vejo muitos trabalhos encorajadores, principalmente vindos de mulheres negras de várias áreas. As pessoas que mais sofrem os impactos negativos, parecem fazer o maior trabalho para sublinhar esse impacto do racismo e os problemas em torno da tomada de decisão algorítmica. É que, quando algo não te afeta, é muito difícil de perceber — logo, as chances de desenvolver uma solução para isso são muito menores. Portanto, vejo muitas comunidades produzindo um trabalho brilhante, que vem mudando a atitude e o discurso. Isso me dá esperança.”

“Por outro lado, vejo que o problema está tão arraigado, que estamos apenas arranhando a superfície. E há muito pensamento redutivo e simplista, como desvenviezar os conjuntos de dados, para algoritmos que, em primeiro lugar, nem deveriam existir. Ou criar um conselho de diversidade e inclusão para lidar com questões raciais profundamente arraigadas, só que composto predominantemente por mulheres brancas.

Podem ser bons primeiros passos, em alguns casos — embora possam fazer mais mal do que bem, em outros — mas precisamos olhar para além disso. Precisamos interrogar as injustiças históricas. Precisamos fazer perguntas difíceis. Por exemplo, a de como as estruturas atuais na academia, tecnologia e sociedade em geral, permitem que certas pessoas — aquelas que satisfazem o status quo — obtenham um passe fácil, enquanto criam obstáculos para aqueles de fora. Como podemos ir além do pensamento em termos de soluções individualistas (como pedir às pessoas que façam testes de preconceito implícito), para pensar em termos mais amplos. Como, por exemplo, criar um ambiente que acolha e preserve estudantes egressos de grupos sociais minoritários?

Você ainda encontra certa atitude defensiva de cientistas que, profissionalmente falando, gostam de pensar que estão acima de qualquer viés ou preconceito?

Falando a partir de minha experiência própria, sim. Você encontra muitas pessoas aderindo a essa ilusão de objetividade — essa ilusão de que estão fazendo ciência “a partir de um ponto de vista neutro”, enquanto muitas vezes “o ponto de vista neutro” é a visão do status quo mascarada como uma visão neutra.

“Infelizmente, grande parte da ciência ocidental é construída sobre as bases dessa ilusão de que podemos nos dissociar de nosso objeto de investigação e medir e analisar as coisas como observadores desinteressados, de longe. Mas, também, cada vez mais você encontra pessoas percebendo que essa ideia de neutralidade é uma ilusão.”

“Culturalmente falando, a sociedade tem uma imagem estereotipada de como um cientista é: um homem branco, usando algum tipo de jaleco branco. Isso significa que aqueles que não se enquadram nesta imagem enfrentam um desafio quando se trata de serem levados a sério como cientistas ou professores.

“Mas eu acho que há cada vez mais compreensão, percepção e conversas com mais nuances, pelo menos no meu círculo da academia. Isso me traz novamente esperanças e me dá coragem.”

Sem publicidade ou patrocínio, dependemos de você. Faça parte do nosso grupo de apoiadores e ajude a manter nossa voz livre e plural: apoia.se/outraspalavras

Um comentario para "Quando a tecnologia nos envia ao passado"